TensorRT--Windows下安装

使用NVIDIA产品进行量化后推理必须使用TensorRT才能加速,否则会默认使用CPU处理,比TensorFlow-GPU推理还慢。这篇文章记录如何在Windows上配置TensorFlow+TensorRT。

基本思路

网上查到:先安装CUDA+cuDNN,下载对应版本的TensorRT将lib和include文件夹下的文件移到CUDA文件下覆盖即可。

安装过程

实际操作我是先下载了TensorRT-8.4.0.6.Windows10.x86_64.CUDA-11.6.cuDNN8.3.zip包,对应CUDA 11.6和cuDNN 8.3,但是离谱的是在cuDNN官网上找不到适用CUDA 11.6版本的cuDNN,只好下了一个cuDNN 8.4 for CUDA 11.x,最后发现也能行。

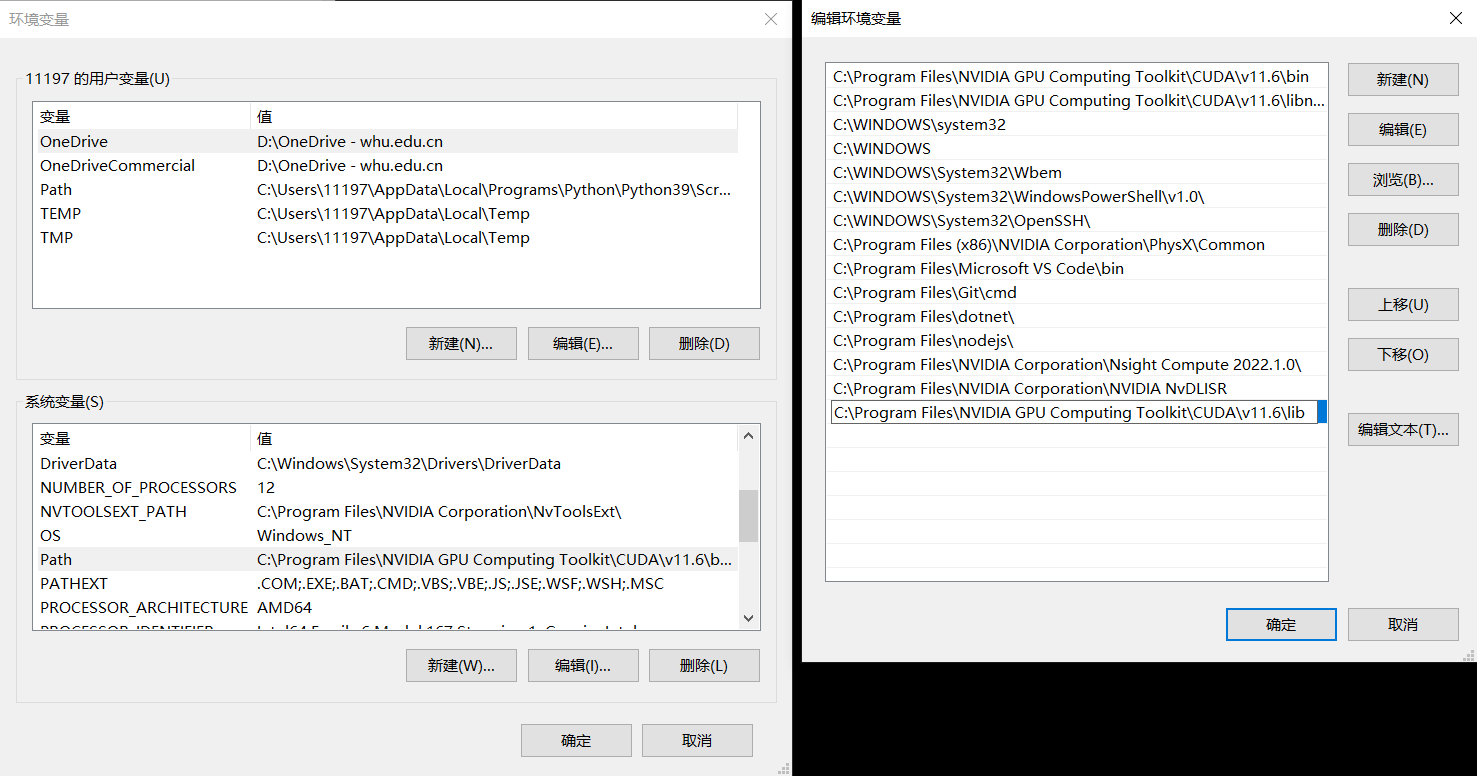

根据NVIDIA官方文档,需要将下载后的TensorRT lib添文件夹加到系统路径(后面把include文件夹也添加扔进去了,不知道实际上需不需要),有两种方法:

- 去系统路径添加

lib文件夹 - 将

lib文件夹复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vX.Y\bin目录下 - 打开

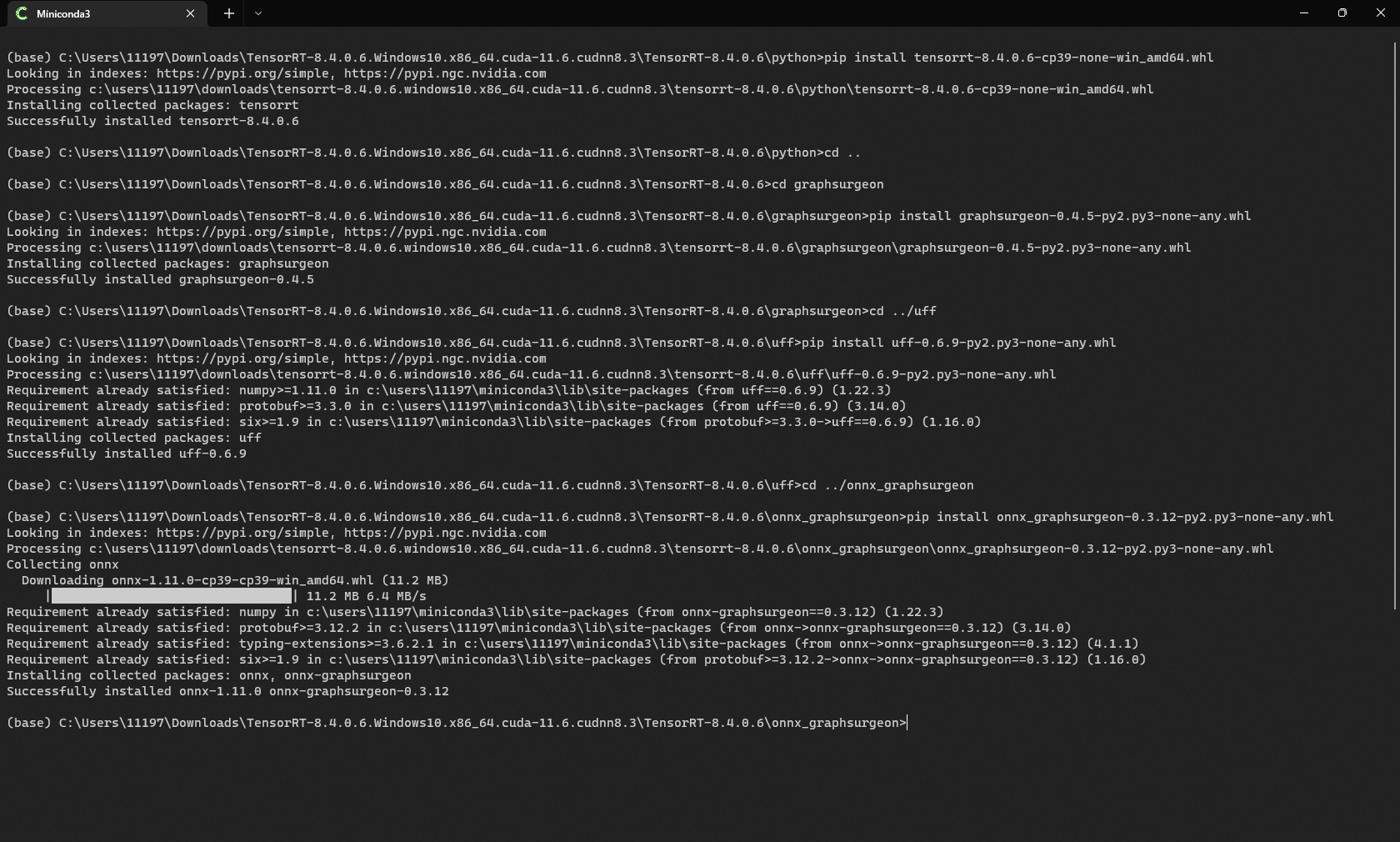

python子目录,安装tensorrt的wheel

在python内导入tensorrt,出现错误FileNotFoundError: Could not find: nvinfer.dll. Is it on your PATH?

1 | (base) C:\WINDOWS\system32>python |

打开TensorRT的__init__.py文件,发现find_lib函数如下:

1 | def find_lib(name): |

所有的lib都是在“Path”名称的变量下搜索的,因此在里面添加nvinfer.dll所在的目录

安装完成!

顺便安装一下pycuda,之后会用到。

1 | (base) C:\WINDOWS\system32>pip install pycuda |

参考文献

赏

支付宝打赏

支付宝打赏

微信打赏

微信打赏

支付宝打赏

支付宝打赏

微信打赏

微信打赏

赞赏是不耍流氓的鼓励